报告题目:可泛化文本-图像跨模态行人检索研究

报告时间:2024年6月12日10:00-11:00

报告地点:计算机学院B404会议室

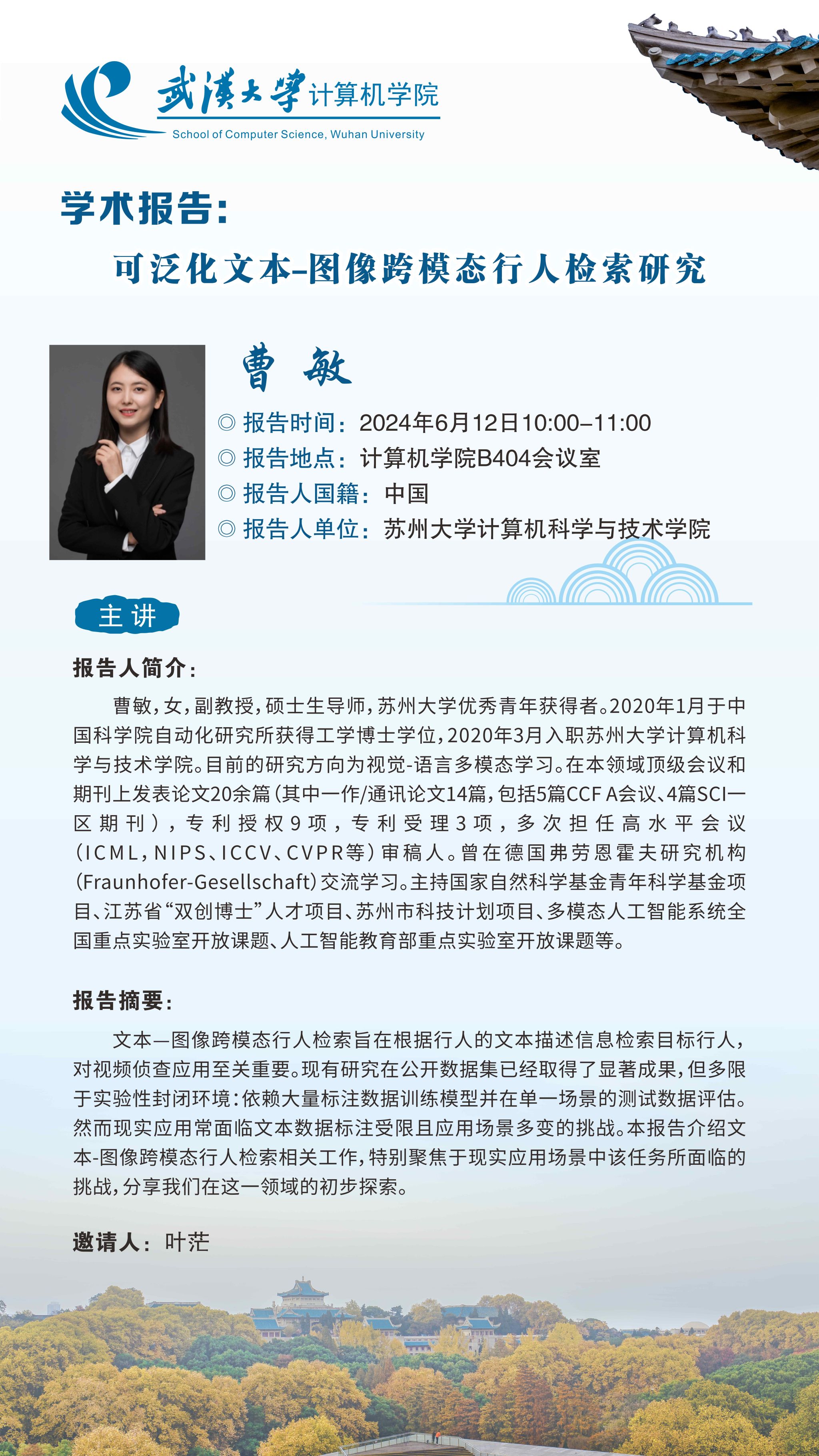

报告人:曹敏

报告人国籍:中国

报告人单位:苏州大学计算机科学与技术学院

报告人简介:曹敏,女,副教授,硕士生导师,苏州大学优秀青年获得者。2020年1月于中国科学院自动化研究所获得工学博士学位,2020年3月入职苏州大学计算机科学与技术学院。目前的研究方向为视觉-语言多模态学习。在本领域顶级会议和期刊上发表论文20余篇(其中一作/通讯论文14篇,包括5篇CCF A会议、4篇SCI一区期刊),专利授权9项,专利受理3项,多次担任高水平会议(ICML,NIPS、ICCV、CVPR等)审稿人。曾在德国弗劳恩霍夫研究机构(Fraunhofer-Gesellschaft)交流学习。主持国家自然科学基金青年科学基金项目、江苏省“双创博士”人才项目、苏州市科技计划项目、多模态人工智能系统全国重点实验室开放课题、人工智能教育部重点实验室开放课题等。

报告摘要:文本-图像跨模态行人检索旨在根据行人的文本描述信息检索目标行人,对视频侦查应用至关重要。现有研究在公开数据集已经取得了显著成果,但多限于实验性封闭环境:依赖大量标注数据训练模型并在单一场景的测试数据评估。然而现实应用常面临文本数据标注受限且应用场景多变的挑战。本报告介绍文本-图像跨模态行人检索相关工作,特别聚焦于现实应用场景中该任务所面临的挑战,分享我们在这一领域的初步探索。

邀请人:叶茫